Python3爬虫实战JS加解密逆向教程 中文完整版

在Python编程领域,Web爬虫是一项重要的技能,用于自动化数据抓取。本教程"Python3爬虫实战JS加解密逆向教程"聚焦于如何处理JavaScript加密和混淆的数据,以便在爬虫过程中获取有效信息。这通常涉及到对前端JavaScript代码的理解、逆向工程以及加解密算法的应用。下面,我们将深入探讨这一主题。

了解JavaScript在网页中的作用至关重要。网页上的许多动态内容是由JavaScript生成的,这些内容往往不会在原始HTML中直接呈现,而是通过Ajax请求和JavaScript逻辑来处理。因此,爬虫必须能够解析和执行JavaScript代码,才能获取到这些隐藏数据。

Python的Selenium库是一个常用工具,它可以模拟浏览器行为,动态加载和执行JavaScript。通过Selenium,我们可以控制浏览器打开网页,执行JavaScript,然后捕获生成的数据。这对于处理那些依赖用户交互或动态加载内容的网站特别有用。

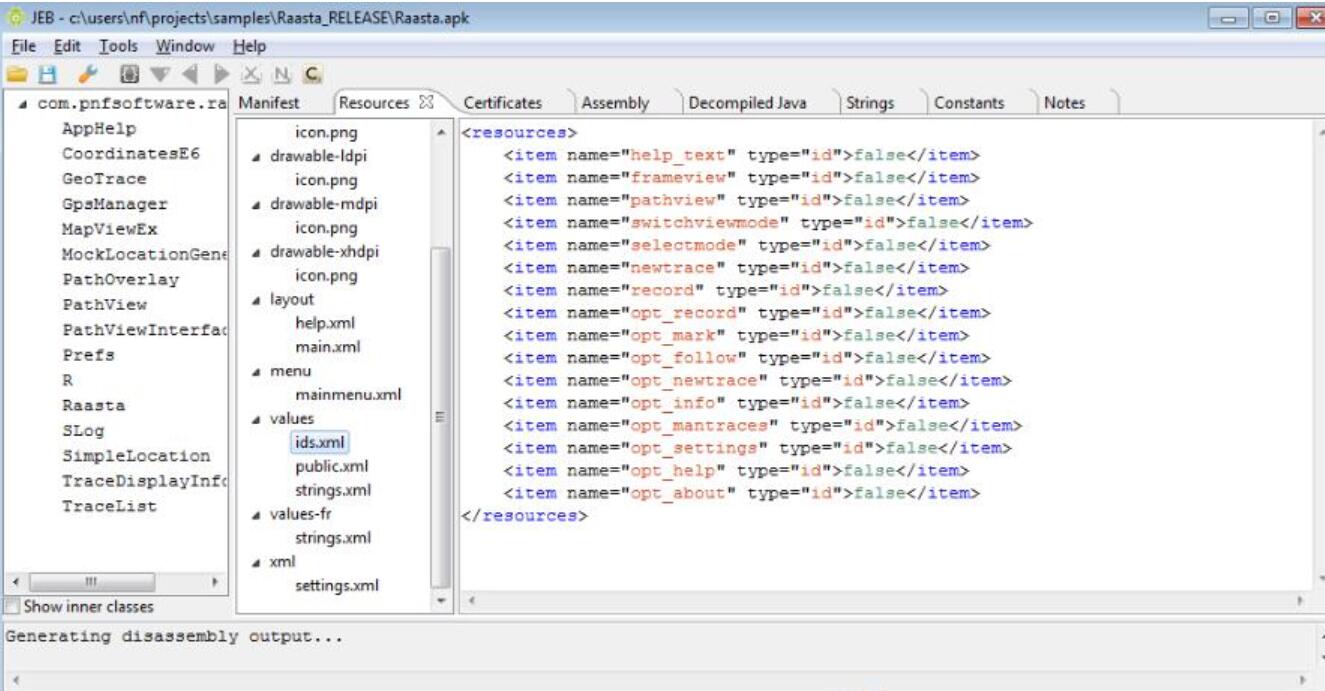

另一个关键概念是JavaScript的逆向工程。在许多情况下,网页会使用各种加密或混淆技术来保护敏感数据,如API密钥或防止爬虫抓取。逆向工程就是要理解并重构这些代码,以便可以解密或绕过这些保护措施。Python的JSBeautifier或Babel可以用来格式化和转换JavaScript代码,使其更易于阅读和分析。

接下来,我们需要掌握一些常见的JavaScript加密算法,如AES、RSA、MD5或SHA家族。Python的PyCryptodome库提供了这些加密算法的实现,可以帮助我们在Python环境中解密JavaScript中的加密数据。此外,对于基于哈希的加密,例如MD5或SHA,我们还需要了解如何生成哈希碰撞或使用彩虹表进行破解。

混淆JavaScript是一种常见的反爬策略,它通过改变变量名、函数名和代码结构来使代码变得难以理解。Python的Esprima或Slimit库可以用来解析和分析JavaScript语法,帮助我们还原混淆代码的原始逻辑。

在实际应用中,我们可能还会遇到验证码、IP封锁等挑战。这时,OCR(光学字符识别)技术可以用于识别验证码,而代理服务器则可以用来绕过IP限制。Python的Tesseract和PyQuery库可用于OCR处理,而Proxies模块则可以管理代理列表。

了解并遵守网站的robots.txt文件和相关法律法规是每个爬虫开发者的基本职责。不要滥用爬虫技术,尊重网站的版权和用户隐私。

总结来说,"Python-Python3爬虫实战JS加解密逆向教程"涵盖的内容包括但不限于:使用Selenium进行动态内容抓取,JavaScript逆向工程,理解并应用加密算法,处理混淆代码,以及应对验证码和IP限制等。掌握这些技能将使你能够处理更为复杂的网络爬虫项目,从而有效地提取和分析网页数据。